Optimaliserte AI-bilder med Apple Silicon

Stable Diffusion med Core ML kan snarlig kjøres optimalisert for såvel macOS som iOS.

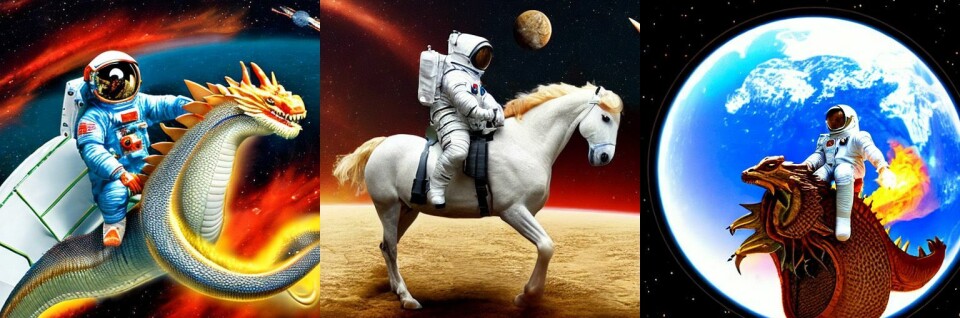

Før malte vi med pensel, så med iPad. Nå maler vi med tastaturet.

Bruken av kunstig intelligens til å generere syntetiske bilder har virkelig tatt av i det siste, og takket være åpen kildekode-prosjekter som Stable Diffusion så har dette blitt tilgjengelig for hvem som helst (med nyere Apple-maskinvare).

Fordelen med Stable Diffusion er at programvare en gratis, i tillegg til å kunne kjøre med lokale modeller. Da slipper man å ha en nettforbindelse, og utviklere kan kutte kostnader siden det ikke blir behov for servere. Og personvernet ivaretas bedre.

Og med lokale modeller for kunstig intelligens gir det god mening å optimalisere også for nevrale nettverk og all regnekraften som sitter i Apples egne brikker. Stable Diffusion vil snarlig kunne dra veksler på optimaliseringer Apple har gjort for Core ML, grensesnittet for maskinlæring på Apples hardware.

Gleden vil slå ut i full blomst under macOS 13.1 og iOS 16.2 - som forventes hvert øyeblikk. For de som er interessert så kan man ta en titt på kode Apple har stilt til disposisjon (GitHub) for å konvertere modeller til eget filformat, med eksempler for Python og Swift.

Lyst til å teste selv? Prøv DiffusionBee for Mac her.

Via Apple