1.000.000.000.000.000.000 operasjoner i sekundet

FREDAGSTECH: Spennende smånyheter som du kanskje har gått glipp av denne uken: Superdatamaskin en størrelsesorden kraftigere, fotokunst med AI, umenneskelig robothånd.

1.000.000.000.000.000.000 operasjoner i sekundet

Det foregår et datamaskinkappløp i verden. I flere år har Kina og USA konkurrert om hvem som har den kraftigste superdatamaskinen, der Kina lenge ledet med sitt Sunway TaihuLight-system. I nyere tid har USA tatt tilbake topplasseringen på den eksklusive Top 500-listen over verdens kraftigste datamaskiner, og på den nyeste utgaven av listen fra november 2018 finner vi de amerikanske maskinene Summit og Sierra på de to øverste plassene, over det kinesiske systemet.

Måleenheten for ytelsen til disse maskinene er «flops» - flyttallsoperasjoner per sekund. Siden disse maskinene er svært kraftige, må vi i tillegg ha et SI-prefiks foran, for millioner, milliarder og så videre. Ytelsen til Summit-systemet på toppen av novemberlista er oppgitt til 143.500 teraflops, eller 143,5 petaflops.

«Peta» betyr en norsk billiard, et ettall etterfulgt av 15 nuller. Topp 500-listen bruker teraflops som enhet nå, fordi alle maskinene på listen har ikke petaflops-ytelse. På tiendeplass på listen er det et system som yter 17,173 petaflops, og nederst, på 500-plassen er et system som holder 874,8 teraflops. Det eneste norske systemet på denne listen er Uninetts Fram, på 454-plass med 953,6 teraflops.

Nylig har det amerikanske energidepartementet og elektronikkprodusenten Intel kunngjort at de skal bygge en ny superdatamaskin som skal hete Aurora, og stå ferdig i 2021. Aurora løfter ytelsen til slike systemer til neste størrelsesorden – exaskala. Dette er altså en norsk trillion, et ettall med 18 nuller etter seg.

Slike tall er så langt utenfor menneskelig skala at de færreste av oss klarer å forholde oss til dem. Nettsiden Popular Science forsøker å anskueliggjøre det ved å sammenligne med en stabel vanlige bærbare pc-er: Om vi sier at en slik datamaskin yter en milliard flops, så vil en stabel med en milliard slike pc-er ha tilsvarende ytelse som Aurora. Vi synes ikke dette hjelper veldig mye på å fatte. Om en slik laptop er halvannen centimeter tykk, så blir stabelen 15 millioner meter, eller 15.000 kilometer høy, eller cirka tre fjerdedeler av veien ut til der GPS-satellittene går i bane. Vi gir oss der, og nøyer oss med å fastslå at størrelsesordenen her er faktisk astronomisk.

Aurora skal brukes til en rekke forskningsformål i flere disipliner. I pressemeldingen fra Intel nevnes storskala kosmologiske simuleringer, nye tilnærminger for å forutse cellers reaksjon på medikamenter, og oppdage nye materialer for mer effektive solceller som eksempler på bruken. Vi tviler ikke på at denne maskinen vil bli et verktøy for nye vitenskapelige gjennombrudd, og gleder oss litt over at det faktisk ikke er våpenindustrien som skal få den første amerikanske exaskala superdatamaskinen.

Fotokunst med AI

Kunstig intelligens, AI – Artificial Intelligence, forskes det intenst på i hele verden. Vi har sett en lang rekke bruksområder allerede, og i dag bruker vi faktisk AI ofte uten å tenke på det. En talestyrt digital assistent, enten den heter Apple Siri, Google Assistant eller Amazon Alexa, startet livet sitt som en maskinlæringsalgoritme. Innen medisin, kanskje særlig på området diagnostikk, er AI lovt en stor framtid. AI kan for eksempel kjenne igjen mønstre på bilder bedre enn et menneske kan nå, og en AI og en patolog som sammen studerer bilder av mistenkelige føflekker vil kunne diagnostisere bedre og raskere enn noen gang før.

Men AI er ikke bare spiss forskning innen seriøse, viktige områder. Det er også lov å leke seg med mulighetene som åpner seg, og ett av områdene der AI har kommet langt, er på mønstergjenkjenning. Det kan brukes til å gjøre hver og en av oss til fotokunstnere.

It-leverandøren Nvidia, som er mest kjent for å lage grafikkbrikkene som trenges for å dra rundt de mest krevende dataspillene som finnes, har en forskningsavdeling som jobber med AI. Det er ikke så rart som det kanskje kan høres ut – grafikkprosessorer er blant de mest brukte datamaskinene innen AI-disiplinen maskinlæring.

Fra denne AI-laben kommer det flere ting, for eksempel tegneprogrammet GauGAN, som lager fotorealistiske landskapsbilder basert på de enkleste strektegninger. Navnet er en kombinasjon av postimpresjonisten Gaugin og forkortelsen til maskinlæringsteknikken som er brukt: GAN – Generative Adversal Networks.

GAN er et brennaktuelt emne innen AI-forskningen for tiden, fordi de gjør opplæringen av AI-en svært mye enklere enn før. AI-forskerne til Nvidia gav GauGAN en million landskapsbilder fra Flickr til å trene på, og resultatet er imponerende, om enn ikke hundre prosent perfekte.

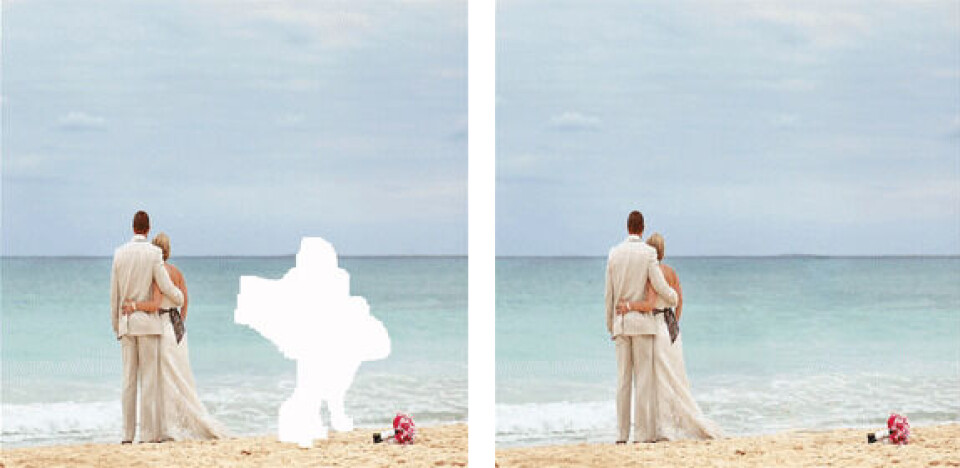

AI-laben til Nvidia har også lagd nettsiden A.I. Playground, der vi kan selv leke med AI-teknikker på interaktive demoer. Når dette skrives er det kun en funksjon for å viske ut uønskete objekter i et foto som er tilgjengelig, men den er kul nok å leke med. Du kan laste opp til eget bilde til nettsiden, også kan du maskere vekk og se AI-en male inn bakgrunnen der du har visket ut.

I tillegg kommer det en funksjon for å endre bilder til kjente kunstneres, som Van Gogh eller Picasso, stil, og en funksjon som genererer fotorealistiske ansikter. Begge disse er merket «under construction» nå, men vi håper at de snart kommer på lufta, for dette er interessant å leke seg med!

Umenneskelig robothånd

De fleste som jobber med å utvikle roboter for tiden, bruker som regel en biologisk modell. De mest utbredte er menneskelignende roboter, noe som jo selvsagt gir mening, både med tanke på interaksjon med mennesker og bruke redskaper som er lagd for mennesker.

Vi har jo alle frydet oss over robotene fra Boston Dynamics, både den menneskelignende tobeinte roboten Atlas, som klarer å hoppe med svært menneskelige bevegelser, eller den mer hundelignende roboten Spot, som beveger seg som et firbeint dyr, og som til og med kan danse. Den tyske «bioniske hånden» fra selskapet Festo var også virkelig imponerende.

Men det finnes forskere som fokuserer på funksjonen, ikke å etterligne våre egne egenskaper. Nyhetssiden til anerkjente Massachusetts Institute of Technology forteller om et prosjekt der forskerne har lagd en «hånd» som ikke ligner på noe fra dyreriket. MIT-forskernes løsning kaller de «Origami Robot Gripper», og det nærmeste biologiske vi kommer på som sammenligning, er en kjøttetende plante.

Designet er likevel svært egnet for robotbruk. Løsningen er myk, slik at den kan løfte skjøre ting, samtidig som den er sterk – forskerne har fått den til å gripe og holde objekter som er 100 ganger tyngre enn sin egen vekt. «Hånden» kan også løfte en lang rekke forskjellige ting uten å ha fått spesialopplæring på hvert enkelt objekt, noe mer menneskelignende gripeanordninger trenger.

Dette er skikkelig utenfor-boksen-tenking, og kanskje roboten som i framtiden pakker handleposen din med varer på supern slett ikke kommer til å ligne noe menneskelig?